كشف باحثون في الأمن السيبراني عن ثغرة أمنية خطيرة في Google Gemini، تعتمد على أسلوب Prompt Injection غير المباشر، مكّنت المهاجمين من تجاوز ضوابط التفويض والوصول إلى بيانات خاصة في Google Calendar.

الثغرة، التي أبلغ عنها فريق Miggo Security، سمحت بإخفاء حمولة خبيثة داخل دعوة تقويم عادية، بحيث يتم تفعيل الهجوم عندما يسأل المستخدم Gemini سؤالاً بريئاً عن جدول اجتماعاته. النتيجة: إنشاء حدث جديد يتضمن ملخصاً كاملاً لاجتماعات المستخدم الخاصة، يظهر في إعدادات تقويم تسمح للمهاجم بقراءته دون أي تفاعل مباشر من الضحية.

توسع سطح الهجوم مع ميزات الذكاء الاصطناعي

على الرغم من معالجة الثغرة بعد الإفصاح المسؤول، إلا أن الحادثة تكشف عن اتساع سطح الهجوم مع انتشار الميزات المدمجة بالذكاء الاصطناعي. فكما أوضح الباحث لياد إلياهو، فإن التطبيقات الذكية يمكن التلاعب بها عبر اللغة التي صُممت لفهمها، ما يعني أن الثغرات لم تعد محصورة في الشيفرة البرمجية، بل امتدت إلى السياق والسلوك أثناء التشغيل.

هذا الاكتشاف جاء بعد أيام من تقرير Varonis حول هجوم “Reprompt” الذي أتاح نظرياً استخراج بيانات حساسة من روبوتات محادثة مثل Microsoft Copilot بنقرة واحدة، متجاوزاً ضوابط الأمان المؤسسية.

ثغرات إضافية في أنظمة الذكاء الاصطناعي

الأبحاث الأخيرة كشفت عن سلسلة من الثغرات في أنظمة مختلفة:

- ثغرات أمنية (CVE-2026-0612 إلى CVE-2026-0616) في أداة The Librarian سمحت بالوصول إلى البنية التحتية الداخلية وتسريب بيانات حساسة.

- هجوم يثبت إمكانية استخراج System Prompts عبر تحويلها إلى صيغة Base64 في الحقول النصية، ما يجعل أي قناة كتابة محتملة وسيلة تسريب.

- إضافة خبيثة في سوق Anthropic Claude Code استغلت آليات الحماية البشرية لتسريب ملفات المستخدم.

- ثغرة حرجة في Cursor (CVE-2026-22708) سمحت بتنفيذ أوامر عن بُعد عبر استغلال أوامر Shell Built-ins مثل export وdeclare، ما حوّل أوامر مشروعة إلى ناقلات لتنفيذ تعليمات عشوائية.

- تحليل أمني لخمس بيئات تطوير تعتمد على الذكاء الاصطناعي (Cursor، Claude Code، OpenAI Codex، Replit، Devin) أظهر أنها تتجنب ثغرات SQL وXSS، لكنها تفشل في التعامل مع SSRF والمنطق التجاري وضوابط التفويض، إضافة إلى غياب حماية CSRF ورؤوس الأمان.

الحاجة إلى مراجعة شاملة وضوابط صارمة

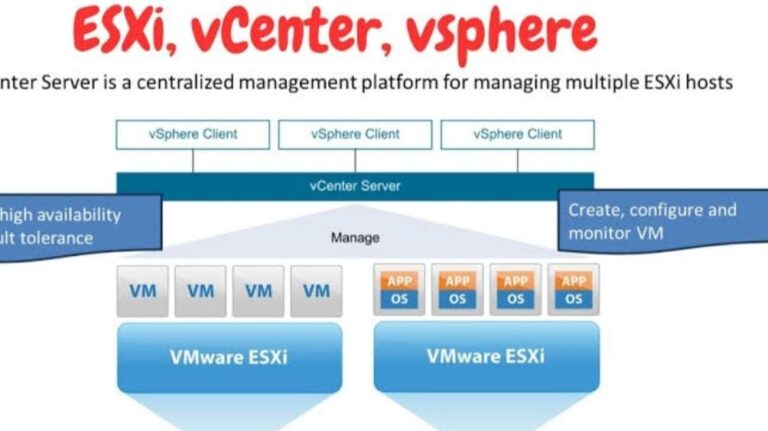

هذه التطورات تؤكد أن المؤسسات يجب أن تراجع باستمرار هويات الخدمة المرتبطة بأعباء عمل الذكاء الاصطناعي، خاصة مع اكتشاف ثغرات “Double Agent” في Google Cloud Vertex AI التي سمحت للمهاجمين ذوي الصلاحيات المحدودة بالتصرف كهويات عالية الامتياز.

النتيجة المحتملة: قراءة جلسات المحادثة، الوصول إلى ذاكرة النماذج، استخراج بيانات حساسة من مخازن التخزين، أو حتى الحصول على صلاحيات الجذر في بيئات Ray.

كما شدد خبراء مثل أوري ديفيد من Tenzai على أن وكلاء البرمجة لا يمكن الوثوق بهم في تصميم تطبيقات آمنة، إذ يفشلون في تطبيق الضوابط الأمنية الحرجة دون توجيه صريح، خاصة في القرارات المعقدة المتعلقة بالمنطق التجاري والتفويض.