تواجه مراكز عمليات الأمن (SOC) اليوم ضغوطًا غير مسبوقة. فوفقًا لتقرير SACR’s AI-SOC Market Landscape 2025، تتعامل المؤسسات مع ما معدله 960 تنبيهًا أمنيًا يوميًا، بينما تتجاوز المؤسسات الكبرى 3,000 تنبيه يوميًا من 28 أداة مختلفة في المتوسط. والأسوأ أن 40% من هذه التنبيهات لا يتم التحقيق فيها مطلقًا، فيما يعترف 61% من فرق الأمن بأنهم تجاهلوا تنبيهات ثبت لاحقًا أنها كانت حرجة.

النتيجة واضحة: النموذج التقليدي لمراكز SOC لم يعد قادرًا على مواكبة التهديدات.

لقد انتقل الذكاء الاصطناعي من مرحلة التجريب إلى مرحلة التطبيق العملي داخل هذه المراكز، حيث تخطط 88% من المؤسسات التي لم تعتمد بعد أنظمة ذكاء اصطناعي في SOC إلى تقييم أو تنفيذ أحدها خلال العام المقبل.

لكن مع ازدياد عدد الشركات التي تسوّق لما تسميه “أتمتة SOC مدعومة بالذكاء الاصطناعي”، تغيّر التحدي من الوعي إلى التقييم: لم يعد السؤال هل ينبغي إدخال الذكاء الاصطناعي إلى SOC، بل كيف يمكن قياس تأثيره الحقيقي واختيار المنصة المناسبة دون تعريض المؤسسة لمخاطر جديدة.

التحول الذهني: من المركز التقليدي إلى مركز الأمن الحديث

إن بناء SOC مدعوم بالذكاء الاصطناعي يبدأ بتغيير المفهوم لا بشراء التقنية.

تعتمد المراكز التقليدية على القواعد الثابتة والفرز اليدوي وردّ الفعل، مما يرهق المحللين ويؤدي إلى ما يعرف بـ”إرهاق التنبيهات”.

أما المراكز الحديثة فتعمل بمنهج مختلف: ينتقل المحللون من أداء المهام يدويًا إلى توجيه النظام والإشراف على نتائجه والتحقق من قراراته ووضع السياسات التي تحكم الأتمتة.

الهدف من هذا التحول بسيط وواضح:

-

الحد من إرهاق التنبيهات ومنع تفويت الحوادث الحرجة.

-

ضمان التحقيق في كل تنبيه أمني.

-

رفع الإنتاجية وتوسيع قدرات المركز دون الحاجة لتوظيف إضافي.

إذن، الخطوة الأولى ليست اختيار المنصة، بل إعادة تعريف نموذج SOC ذاته وتحديد دوافع هذا التغيير.

نماذج البنى المعمارية لـ AI-SOC وإطار التنفيذ

يُقسّم تقرير SACR سوق منصات AI-SOC إلى أربعة أبعاد رئيسة تصف ما تقوم به المنصة، وكيف تُقدّم، وكيف تتكامل، وأين تعمل.

1. النطاق الوظيفي: ما الذي تقوم بأتمتته؟

-

التحكم والأتمتة (SOAR+) وSOC العامل بالوكلاء الذكيين:

يعمل كالجهاز العصبي للمركز، منسّقًا بين أدوات SIEM وEDR والخدمات السحابية وأنظمة التذاكر. يمتاز بقدرته على تنفيذ قرارات احتوائية تلقائيًا والتكيّف مع المواقف دون الاعتماد على “كتيّبات ثابتة”. -

التحليل الذكي للتنبيهات (Pure-Play Agentic Triage):

يركّز على مشكلة فيض التنبيهات، إذ يتيح لوكلاء ذكاء اصطناعي إجراء تحقيق أولي وتصفية التنبيهات الزائفة قبل التصعيد إلى المحللين. -

المساعد التحليلي (Analyst Co-Pilot):

يعمل كمساعد رقمي للمحللين البشريين، يقدّم ملخصات للأدلة وسياقات الحوادث ويساعد في صياغة الاستفسارات التحقيقية. -

استنساخ المعرفة التشغيلية:

يسجّل كيف يتعامل الخبراء مع الحوادث ويعيد تشغيل هذه الخطوات آليًا لضمان الاتساق ونقل الخبرة داخل الفرق.

2. نموذج التنفيذ: كيف تُقدّم المنصة؟

-

منصات قابلة للتخصيص (User-Defined):

تتيح التحكم الكامل في تصميم الوكلاء والمنطق التحليلي، لكنها تحتاج إلى خبرات تقنية عالية وصيانة مستمرة. -

منصات جاهزة التشغيل (Pre-Packaged):

تُدار من قبل المزوّد، وتُطبّق بسرعة مع تحديثات مستمرة، لكنها تفتقر إلى الشفافية والتحكم الداخلي.

3. نوع البنية: كيف تتكامل؟

-

منصات AI-SOC المتكاملة (Integrated):

تقوم بتحليل البيانات الخام مباشرة، ما يجعلها بديلًا عن أنظمة SIEM التقليدية، وتمنح رؤية موحدة وخفضًا لتكاليف التخزين والترخيص. -

النموذج المتصل أو المضاف فوق النظام الحالي (Connected & Overlay):

يضيف طبقة ذكاء اصطناعي فوق الأنظمة القائمة دون تعديل البنية التحتية. سريع في النشر لكنه يعتمد على جودة التنبيهات من الأدوات الأصلية. -

المحاكاة السلوكية للمحللين (Human Workflow Emulation):

يراقب أداء المحللين ويعيد تكراره آليًا، ما يعزّز الاتساق ويستنسخ الخبرات.

4. نموذج النشر: أين تعمل المنصة؟

-

SaaS: مستضافة بالكامل لدى المزوّد وسريعة النشر.

-

BYOC (Bring Your Own Cloud): البنية التحتية والبيانات تبقى ضمن بيئة العميل.

-

On-Prem معزولة (Air-Gapped): مخصصة للقطاعات الحساسة التي لا تسمح باتصال خارجي.

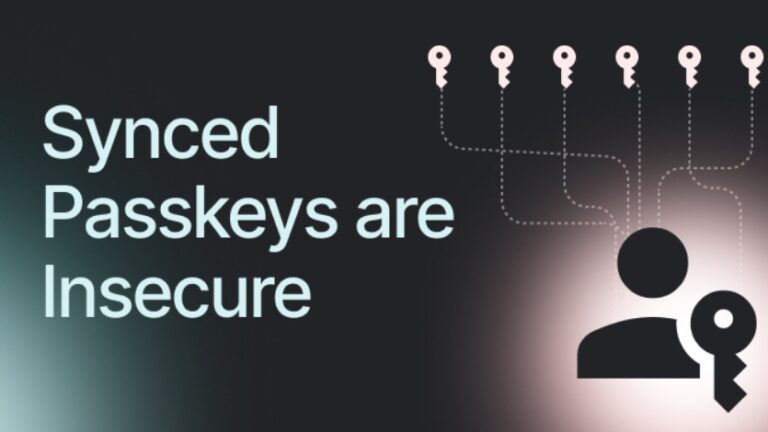

المخاطر والعوامل الواجب مراعاتها قبل التبنّي

رغم الوعود الكبيرة بالكفاءة والسرعة، تُدخل أنظمة AI-SOC مخاطر جديدة يجب إدارتها:

-

غياب معايير قياس موحدة للأداء والدقة يجعل المقارنات بين المزوّدين صعبة.

-

ضبابية القرار (مخاطر التفسير): بعض الأنظمة تعمل كصندوق أسود بلا شفافية في طريقة التحليل.

-

قضايا الامتثال والخصوصية في الأنظمة السحابية التي تعالج بيانات حساسة.

-

خطر الارتباط بالمزوّد (Vendor Lock-in) نتيجة تخزين البيانات داخليًا.

-

تحولات المهارات والإدارة، إذ يتحول دور المحلل من التحقيق اليدوي إلى الإشراف على الأتمتة.

-

تعقيد التكامل مع أنظمة SIEM وEDR القائمة.

-

الاعتماد المفرط على الأتمتة دون رقابة بشرية.

-

تراجع أداء النماذج بمرور الوقت (Model Drift) ما لم تُحدّث بانتظام.

-

مخاطر اقتصادية ناتجة عن نماذج تسعير تعتمد على حجم البيانات المُعالَجة.

تبدأ الحماية من هذه المخاطر بالشفافية واختيار المنصات التي تقدم قابلية تفسير عالية وتكاملًا مرنًا وتوازنًا واضحًا بين الأتمتة والتحكم البشري.

أسئلة يجب طرحها على مزوّد منصة AI-SOC

-

الكشف والتحليل: ما نسبة التنبيهات التي تُحلل تلقائيًا؟ وهل يمكن تدقيق قرارات الذكاء الاصطناعي؟

-

ملكية البيانات: من يملك بيانات التنبيهات؟ وأين تُخزّن؟

-

التحكم البشري والتفسير: هل يمكن للمحللين تعديل قرارات النظام؟ وما الضمانات ضد الأفعال التلقائية الخاطئة؟

-

التكامل مع البنية القائمة: هل تتوافق المنصة مع أدوات SIEM وEDR الحالية دون ازدحام بالواجهات؟

-

التكلفة والتوسع: كيف تتدرج الأسعار مع زيادة حجم البيانات أو عدد المستخدمين؟

الهدف من هذه الأسئلة هو التمييز بين قدرات حقيقية وادعاءات تسويقية.

إطار التبنّي المرحلي لمنصة AI-SOC

يقدم تقرير SACR إطارًا عمليًا للتبني الآمن والمتدرج:

-

تحديد الاستراتيجية وربطها بأهداف العمل.

-

اختيار القدرات الجوهرية مثل تحليل التنبيهات والاستجابة الآلية والشفافية.

-

تشغيل نموذج إثبات المفهوم (POC) لقياس الأداء باستخدام بيانات حقيقية.

-

مرحلة بناء الثقة (1–2 شهر) عبر تشغيل النظام في وضع المساعدة.

-

التدرج في الأتمتة بدءًا من الحوادث منخفضة الخطورة.

-

المراجعة المستمرة لأداء النماذج وفعالية التكامل.

مؤشرات النجاح عبر الزمن

-

قصير المدى (0–3 أشهر): انخفاض مدة تحليل التنبيهات وزيادة تغطية الحوادث.

-

متوسط المدى (3–9 أشهر): تقليص الوقت المتوسط للاستجابة (MTTR) وتقليل الإنهاك الوظيفي للمحللين.

-

طويل المدى (9 أشهر فأكثر): ثبات الأداء، وتكلفة تشغيل متوقعة، وتحسين التقارير الرقابية.

تُعيد منصات AI-SOC رسم مشهد الأمن السيبراني الحديث، لكن النجاح فيها لا يتحقق بالتقنية وحدها، بل بفهم البنية والمخاطر واعتماد الأتمتة التدريجية التي تبني الثقة وتضمن الشفافية.

الفرق التي توفّق بين كفاءة الذكاء الاصطناعي وحكمة الإنسان هي التي ستقود مراكز الأمن إلى مرحلة أكثر مرونة وفعالية.