أصبحت المكانة المتنامية للذكاء الاصطناعي في بيئات الأعمال تفرض على مسؤولي أمن المعلومات (CISOs) قيادة جهود حوكمة فعّالة لهذا المجال. فالتعامل مع التقنيات الناشئة غالبًا ما يبدأ بردود أفعال تقليدية مثل صياغة لوائح صارمة وتعميمها على الموظفين، غير أن الحوكمة الفعّالة لا تقتصر على وثائق مكتوبة، بل تمثل نظامًا حيًا يوجّه الاستخدام اليومي للتقنية، ويوازن بين الابتكار السريع ومتطلبات الأمان. فالتقدم بلا ضوابط قد يؤدي إلى تسرب بيانات حساسة أو انتشار ظاهرة “الذكاء الاصطناعي الموازي” (Shadow AI)، بينما البطء الشديد يترك المؤسسة متأخرة أمام المنافسين.

فهم الواقع العملي داخل المؤسسات

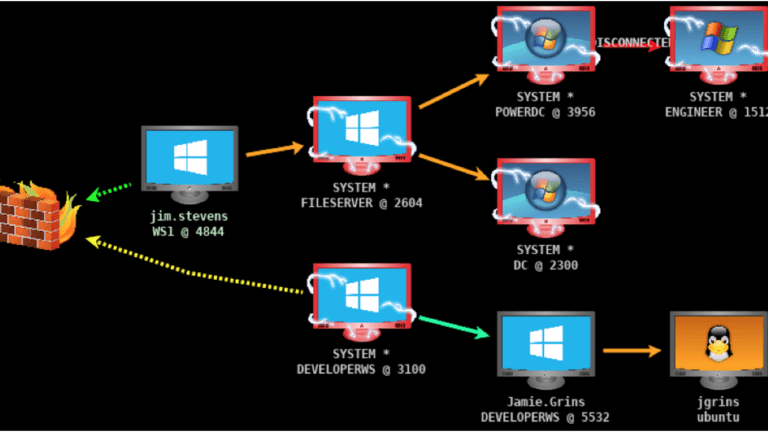

مع ظهور أدوات مثل ChatGPT أواخر 2022، لجأ العديد من مسؤولي الأمن إلى سياسات حظر صارمة، لكن هذه المقاربة لم تثبت فعاليتها أمام سرعة التطور. المطلوب هو بناء حوكمة قائمة على “الواقع الميداني” داخل المؤسسات، وفهم أماكن وجود الذكاء الاصطناعي وكيفية استخدامه. أدوات مثل قوائم مكونات الذكاء الاصطناعي (AIBOM) تساعد على كشف مصادر البيانات والمخاطر، بينما تعمل سجلات النماذج على متابعة أداء الأنظمة المستخدمة ومنع “التوسع العشوائي للصناديق السوداء”. أما اللجان المشتركة بين الأمن والتقنية والقانون والموارد البشرية، فهي تضمن أن تكون الحوكمة مسؤولية جماعية مرتبطة بالنتائج العملية.

سياسات مرنة تواكب وتيرة التبني

الوقوع في فخ السياسات السريعة التنفيذ والضعيفة التطبيق أحد أكبر تحديات الحوكمة. ففي حالات عديدة، أُجبر مسؤولو الأمن على حظر شامل لتقنيات الذكاء الاصطناعي بانتظار منصة موحدة لم تُعتمد لاحقًا، ما فتح الباب أمام استخدام أدوات غير مصرح بها. الحل يكمن في صياغة سياسات حية قابلة للتطور تواكب التغيرات الإدارية والوظيفية، وتترجم إلى معايير وإجراءات يومية يفهمها الموظفون وتُطبق عمليًا.

استدامة الحوكمة عبر التمكين

الهدف ليس حظر الذكاء الاصطناعي بل جعل الاستخدام المسؤول الخيار الأسهل والأكثر فاعلية. ويشمل ذلك تزويد الموظفين بأدوات مؤسسية آمنة، وتعزيز السلوكيات الإيجابية عبر التدريب والدعم. كما تدعو إرشادات معهد SANS إلى ركيزتين أساسيتين: استخدام الذكاء الاصطناعي لحماية الأمن السيبراني عبر أتمتة التحليل والتحقق من التهديدات، وحماية أنظمة الذكاء الاصطناعي نفسها من الهجمات العدائية عبر ضوابط ومعايير أمنية متخصصة