الذكاء الاصطناعي التوليدي لا يقتحم الساحة بضجيج، بل يتسلل تدريجيًا إلى التطبيقات السحابية التي تعتمد عليها الشركات يوميًا. من منصات الاجتماعات إلى أدوات إدارة العلاقات مع العملاء (CRM)، تتسابق الشركات لدمج مساعدين ذكيين في برمجياتها. يمكن لتطبيق Slack الآن تلخيص المحادثات، وتقوم Zoom بتلخيص الاجتماعات، وتقدم Microsoft 365 دعمًا ذكيًا في الكتابة والتحليل. هذا التوسع الصامت للذكاء الاصطناعي جعل معظم المؤسسات تستفيق على واقع جديد: قدرات الذكاء الاصطناعي أصبحت جزءًا من بيئة SaaS لديها، دون رقابة مركزية.

أحد الاستطلاعات الحديثة أشار إلى أن 95% من الشركات الأميركية تستخدم الآن الذكاء الاصطناعي التوليدي، وهو ارتفاع كبير خلال عام واحد فقط. لكن هذا التبني الواسع ترافقه مخاوف متزايدة، حيث بدأ القادة في التساؤل عن تأثير هذه الأنشطة الذكية غير المرئية. تتصدر خصوصية البيانات وأمنها قائمة المخاوف، خصوصًا مع حالات شهدنا فيها تسريب معلومات حساسة عن غير قصد، ما دفع بعض المؤسسات الكبرى إلى حظر أدوات مثل ChatGPT داخليًا.

لماذا تُعد حوكمة الذكاء الاصطناعي في SaaS ضرورية؟

نظرًا لتغلغل الذكاء الاصطناعي في تطبيقات الاتصالات وقواعد البيانات، تصبح الحوكمة الوسيلة الوحيدة للاستفادة من هذه القدرات دون المخاطرة بأمن المؤسسة.

ببساطة، حوكمة الذكاء الاصطناعي تعني السياسات والإجراءات والضوابط التي تضمن استخدام الذكاء الاصطناعي بشكل آمن ومسؤول داخل المؤسسة، بما يتماشى مع المتطلبات الأمنية والامتثال والمعايير الأخلاقية. في بيئة SaaS، حيث البيانات تتدفق باستمرار إلى خدمات سحابية خارجية، تصبح هذه الحوكمة أكثر إلحاحًا.

-

تعريض البيانات للخطر: تعتمد خصائص الذكاء الاصطناعي عادة على الوصول إلى كميات كبيرة من المعلومات، مثل سجلات العملاء أو رسائل البريد الصوتي. بدون إشراف، قد تتصل هذه الأدوات بنماذج خارجية وترسل بيانات حساسة دون إذن.

-

انتهاكات الامتثال: قد يؤدي استخدام الذكاء الاصطناعي دون موافقة تكنولوجيا المعلومات إلى خرق قوانين مثل GDPR أو HIPAA، خصوصًا إذا جرى إدخال معلومات شخصية إلى أدوات ترجمة أو مساعدات كتابة دون علم المؤسسة.

-

تحديات تشغيلية: أدوات الذكاء الاصطناعي يمكن أن تنتج قرارات غير دقيقة أو متحيزة، مما يؤثر على الموظفين والعملاء. دون ضوابط، قد تتخذ الأنظمة قرارات تتعارض مع أهداف المؤسسة أو قيمها.

تحديات إدارة الذكاء الاصطناعي في بيئة SaaS

يُصعّب التبني السريع والعشوائي للذكاء الاصطناعي مهمة المراقبة. كثير من الفرق الأمنية لا تعلم بوجود ميزات ذكاء اصطناعي فعّالة في مؤسستها. يمكن للموظفين تفعيل أدوات ذكاء اصطناعي جديدة خلال ثوانٍ دون المرور بأي عملية موافقة، ما يؤدي إلى ظهور “ذكاء اصطناعي خفي” يصعب تتبعه أو التحكم فيه.

كما تسهم ملكية الأدوات المتفرقة بين الإدارات المختلفة في تعقيد الوضع. فكل قسم يستخدم أدوات ذكاء اصطناعي لأغراضه الخاصة: التسويق يستخدم مساعد كتابة، والهندسة تعتمد على مساعد برمجي، والدعم الفني يدمج روبوت محادثة ذكي، دون أي تنسيق أو استراتيجية مركزية. النتيجة: أدوات مختلفة بمعايير أمان متفاوتة، وغياب للمساءلة.

أحد أخطر التحديات هو فقدان تتبع مصدر البيانات عند استخدام الذكاء الاصطناعي. فقد ينقل موظف نصًا حساسًا إلى مساعد كتابة ذكي خارج بيئة الرقابة، ويعود بنتيجة يستخدمها مع العملاء، دون أن تدرك المؤسسة أن البيانات غادرت النظام.

أفضل 5 ممارسات لحوكمة الذكاء الاصطناعي في بيئة SaaS

لبناء إطار فعال للحوكمة، تنصح المؤسسات الرائدة باتباع خطوات عملية تشمل:

-

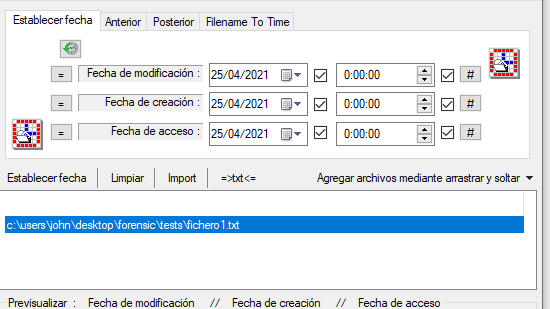

جرد أدوات الذكاء الاصطناعي

ابدأ بحصر كل الأدوات والميزات المعتمدة على الذكاء الاصطناعي داخل المؤسسة، بما في ذلك تلك المدمجة في التطبيقات السحابية المعتادة، والإضافات غير الرسمية. أنشئ سجلًا مركزيًا يتضمن نوع الأداة، الجهة المستخدمة، ونوعية البيانات التي تتعامل معها. -

وضع سياسات واضحة لاستخدام الذكاء الاصطناعي

على غرار سياسات الاستخدام المقبول لتكنولوجيا المعلومات، أنشئ سياسة مخصصة للذكاء الاصطناعي توضح المسموح به والمحظور. مثلاً، يمكن السماح باستخدام مساعد برمجي في المشاريع مفتوحة المصدر، مع حظر إدخال بيانات العملاء لأي أداة غير معتمدة. التوعية بهذه السياسات مهمة لتقليل الأخطاء. -

مراقبة وتقييد الوصول

طبق مبدأ “أقل امتياز ممكن”. لا تمنح أي أداة وصولًا يتجاوز احتياجها. راجع صلاحيات أدوات الذكاء الاصطناعي بشكل دوري، واستخدم سجلات الإدارة في منصات SaaS لمراقبة الأنشطة. استعد للتدخل إذا ظهرت سلوكيات غير متوقعة. -

تقييم المخاطر بشكل مستمر

حوكمة الذكاء الاصطناعي ليست مهمة تُنفذ مرة واحدة. تحتاج إلى مراجعة شهرية أو فصلية لرصد أدوات جديدة، ومتابعة تحديثات مزودي الخدمة، وتعديل السياسات عند ظهور تهديدات جديدة. -

التعاون بين الإدارات

الحوكمة ليست مسؤولية تكنولوجيا المعلومات فقط. ينبغي إشراك الشؤون القانونية، والامتثال، وقيادات الأعمال، وخبراء خصوصية البيانات، لضمان التوازن بين الأمان والابتكار،

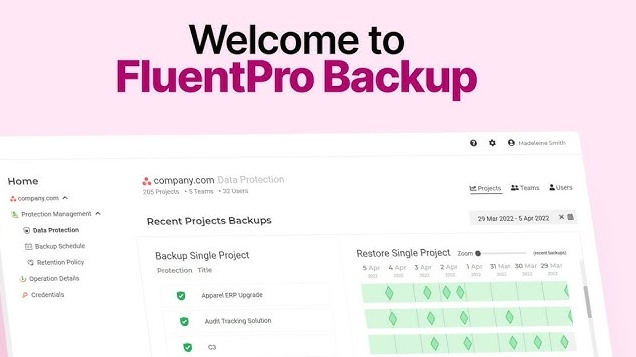

منهجية Reco لحوكمة الذكاء الاصطناعي

رغم أهمية الحوكمة، فإن إدارتها يدويًا عبر مئات التطبيقات السحابية قد تُثقل كاهل فرق الأمن. هنا يأتي دور حلول متخصصة مثل منصة Reco، التي تتيح أتمتة الاكتشاف والمراقبة والتحكم، وتحول السياسات النظرية إلى حماية واقعية على أرض الواقع.