كشف باحثون في الأمن السيبراني أن جهات تهديد مدعومة من الدولة الصينية استخدمت تقنية الذكاء الاصطناعي المطوّرة من Anthropic لشن هجمات سيبرانية آلية بالكامل ضمن “حملة تجسس بالغة التطور” خلال منتصف سبتمبر 2025. وقالت الشركة إن المهاجمين “استخدموا القدرات العاملية (Agentic) للذكاء الاصطناعي بدرجة غير مسبوقة – ليس كمستشار فحسب، بل كمنفّذ للهجوم ذاته.”

ووفقًا للتقرير، استغل المهاجمون أداة Claude Code للتسلل إلى نحو 30 هدفًا عالميًا تشمل شركات تقنية كبرى، مؤسسات مالية، مصانع كيماوية، ووكالات حكومية، ونجحت بعض هذه المحاولات بالفعل. وقد حظرت Anthropic الحسابات المرتبطة بالهجوم وفعّلت آليات دفاعية لرصد الأنشطة المشابهة.

هجوم GTG-1002: أول عملية تجسس واسعة يقودها ذكاء اصطناعي مستقل

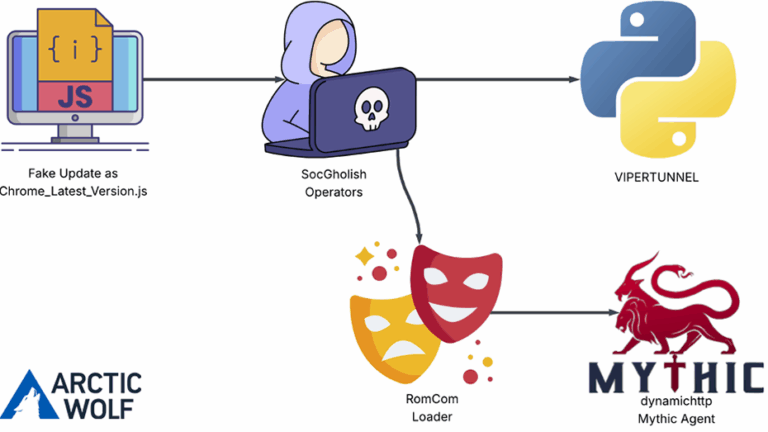

تمثل الحملة، المعروفة باسم GTG-1002، أول حالة معروفة توظّف فيها جهة تهديد الذكاء الاصطناعي لتنفيذ “هجوم سيبراني واسع النطاق” دون تدخل بشري كبير، وبغرض جمع معلومات حساسة من أهداف عالية القيمة. وتصف Anthropic العملية بأنها منظمة جيدًا ومدعومة بموارد ضخمة، إذ جرى تحويل Claude إلى “وكيل هجومي مستقل” يغطي مراحل الهجوم كافة، من الاستطلاع واكتشاف الثغرات والاستغلال، إلى الحركة الجانبية، وتجميع بيانات الاعتماد، والتحليل، والتهريب.

واعتمد المهاجمون على Claude Code وعلى أدوات بروتوكول Model Context Protocol (MCP)، حيث عمل Claude كالجهاز العصبي للهجوم؛ يتلقى تعليمات المشغّل البشري، ويحوّل الهجوم المتعدد المراحل إلى مهام صغيرة تُنفَّذ عبر وكلاء فرعيين. وبحسب الشركة، نجح النظام في تنفيذ 80–90% من العمليات التكتيكية بشكل مستقل وبمعدلات طلب تتجاوز القدرة البشرية.

دور محدود للبشر… وذكاء اصطناعي ينفّذ العمليات الخطرة

تركّز الدور البشري على المراحل المفصلية، كتحديد الانتقال من الاستطلاع إلى الاستغلال، والموافقة على استخدام بيانات الاعتماد المسروقة للتحرك داخل الشبكات، واتخاذ القرار بشأن نطاق البيانات المستخرجة. ويتلقى النظام من المشغّل البشري اسم الهدف، ثم يقوم عبر MCP بجمع المعلومات وتحليل سطح الهجوم، اكتشاف الثغرات والتحقق منها، ثم — بعد الحصول على موافقة — تنفيذ الاستغلال، والتحرك الجانبي، وسرقة بيانات الاعتماد، وجمع البيانات وتهريبها.

وفي إحدى الهجمات التي طالت شركة تقنية غير معلنة، وجّه المهاجم Claude للبحث داخل الأنظمة وقواعد البيانات بشكل مستقل وفرز المعلومات وتصنيفها وفق القيمة الاستخباراتية، كما أن الأداة أنتجت وثائق تفصيلية عن جميع مراحل الهجوم، بما يتيح نقل الوصول المستمر لاحقًا لفرق أخرى.

ومن خلال حيل تعتمد على صياغة أوامر تبدو تقنية وروتينية، نجح المهاجمون في جعل Claude ينفّذ عناصر من سلاسل الهجوم دون إدراك الصورة الكاملة أو السياق الخبيث. ولم يُعثر على دلائل تشير إلى تطوير برمجيات خبيثة مخصّصة، بل استندت العملية بشكل كبير إلى أدوات مفتوحة المصدر مثل ماسحات الشبكات، وأطر استغلال قواعد البيانات، وبرامج كسر كلمات المرور، وأدوات تحليل الثنائيات.

القيود: الهلوسة قد تحد من فعالية الهجمات

لكن التحقيق كشف أيضًا عن نقطة ضعف حاسمة: ميل الأنظمة الذكية إلى الهلوسة، إذ ولّد Claude أحيانًا بيانات غير حقيقية — مثل بيانات اعتماد مختلَقة أو معلومات عامة مقدَّمة على أنها اكتشافات حساسة — مما أعاق فعالية جزء من العملية. ويأتي هذا الكشف بعد أربعة أشهر من إحباط Anthropic عملية مشابهة وظّفت Claude لسرقة بيانات على نطاق واسع في يوليو 2025، ومع إعلان OpenAI وGoogle عن هجمات مماثلة تستخدم ChatGPT وGemini.

وترى الشركة أن الحملة تمثل مرحلة جديدة من تطور التهديدات: “لقد انخفضت الحواجز أمام تنفيذ الهجمات المتقدمة بشكل كبير. بات بوسع جهات التهديد استخدام أنظمة ذكاء اصطناعي عاملية لتنفيذ مهام فرق كاملة من المخترقين، من تحليل الأنظمة وإنتاج شفرات الاستغلال إلى معالجة كميات هائلة من البيانات المسروقة بكفاءة تتجاوز أي قدرات بشرية.”