كشف باحثون في الأمن السيبراني عن تقنية جديدة خطيرة تُعرف باسم “إعادة استخدام مساحة أسماء النماذج” (Model Namespace Reuse)، تمكّن المهاجمين من استغلال خلل جوهري في سلاسل التوريد الخاصة بالذكاء الاصطناعي للحصول على تنفيذ عن بُعد للأكواد (RCE) وصلاحيات إضافية على منصات كبرى مثل Microsoft Azure AI Foundry و Google Vertex AI و Hugging Face.

كيفية عمل الهجوم

تحدث الثغرة عندما تقوم كتالوجات النماذج أو الشفرات الخاصة بمزودي الخدمات السحابية بجلب نموذج محذوف أو منقول بالاعتماد على اسمه فقط. وبإعادة تسجيل مساحة أسماء مهجورة وإعادة إنشاء مسارها الأصلي، يستطيع المهاجمون إدخال نماذج خبيثة إلى خطوط الإنتاج التي تنشر النماذج استنادًا إلى الاسم وحده. هذا الخلل يفتح الباب أمام زرع نماذج ضارة تمنح المهاجمين قدرات واسعة تتجاوز مجرد استبدال النموذج.

تداعيات التهديد

الخطر الأكبر يكمن في أن المطورين الذين يثقون بكتالوجات النماذج السحابية التابعة للمنصات الكبرى قد يقومون، من دون قصد، بنشر نماذج خبيثة سبق أن استضافها Hugging Face، دون الحاجة للتفاعل المباشر مع المنصة. هذا يسلط الضوء على هشاشة سلاسل التوريد في بيئة الذكاء الاصطناعي ويؤكد أن مجرد الثقة في مصدر مركزي قد لا يكون كافيًا.

التوصيات والحماية

يوصي الباحثون باتخاذ عدة إجراءات للحد من المخاطر، أبرزها:

-

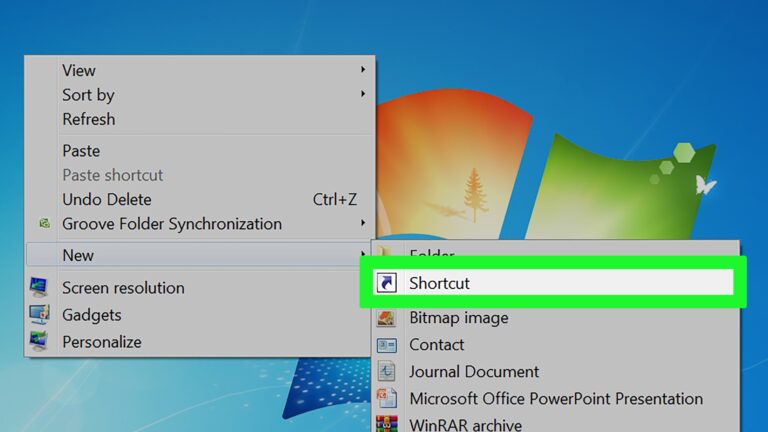

تثبيت النماذج على إصدار محدد (commit) بدل الاعتماد على الاسم فقط.

-

استنساخ النماذج وتخزينها في مواقع موثوقة.

-

التعامل مع مراجع النماذج على أنها اعتمادات برمجية حساسة يجب أن تخضع للسياسات والمراجعة الدقيقة.