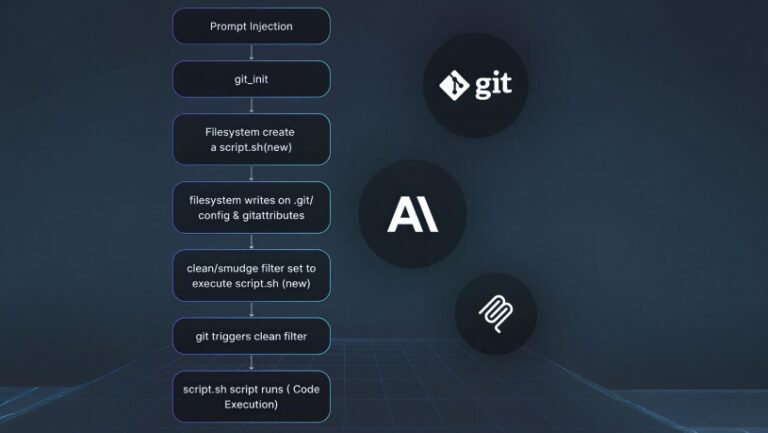

كشفت دراسة أكاديمية جديدة مشتركة بين Anthropic وفريق Safeguards التابع لوكالة AISI البريطانية ومعهد Alan Turing أن إدخال ما يقارب 250 مستندًا خبيثًا فقط إلى بيانات تدريب نموذج لغوي كبير كافٍ لزرع باب خلفي بسيط فيه. وتشكل هذه النتائج تحديًا للمفهوم السائد بأن المهاجمين بحاجة إلى السيطرة على نسبة ضخمة من بيانات التدريب للتأثير على مخرجات النموذج.

هجمات التسميم لم تعد بحاجة إلى بيانات ضخمة

أكد الباحثون أن هجمات تسميم البيانات تتطلب عددًا شبه ثابت من المستندات بغض النظر عن حجم النموذج أو بيانات تدريبه، قائلين: “إذا كان المهاجمون يحتاجون فقط إلى حقن عدد محدود من الوثائق بدلاً من نسبة مئوية من بيانات التدريب، فإن هذه الهجمات قد تكون أكثر قابلية للتنفيذ مما كان يُعتقد سابقًا.”

دراسات سابقة دعمت الاتجاه نفسه

أشارت دراسة سابقة عام 2024 أجراها باحثون من جامعة كارنيغي ميلون وETH زيورخ وMeta وGoogle DeepMind إلى أن السيطرة على 0.1% فقط من بيانات ما قبل التدريب يمكن أن تتيح إدخال أبواب خلفية تخدم أغراضًا خبيثة متنوعة. وتتماهى الدراسة الجديدة مع تلك النتائج، مؤكدة أن عدد البيانات المسمومة المطلوبة لا يزداد مع حجم النموذج، وهو ما يجعل النماذج الأكبر أكثر عرضة لهذا النوع من الهجمات مما كان متوقعًا.

دعوة لتعزيز أبحاث الدفاع السيبراني

وشدد الباحثون على الحاجة الماسة إلى تطوير آليات دفاعية أكثر فعالية لحماية النماذج المستقبلية من التلاعب بالبيانات خلال مراحل التدريب. يأتي هذا في وقت أعلنت فيه OpenAI أن نموذجها GPT-5 أظهر مستويات تحيز سياسي أقل من أي إصدار سابق، في إشارة إلى السعي المتواصل لتحسين سلامة النماذج من التحيز والاختراق على حد سواء.