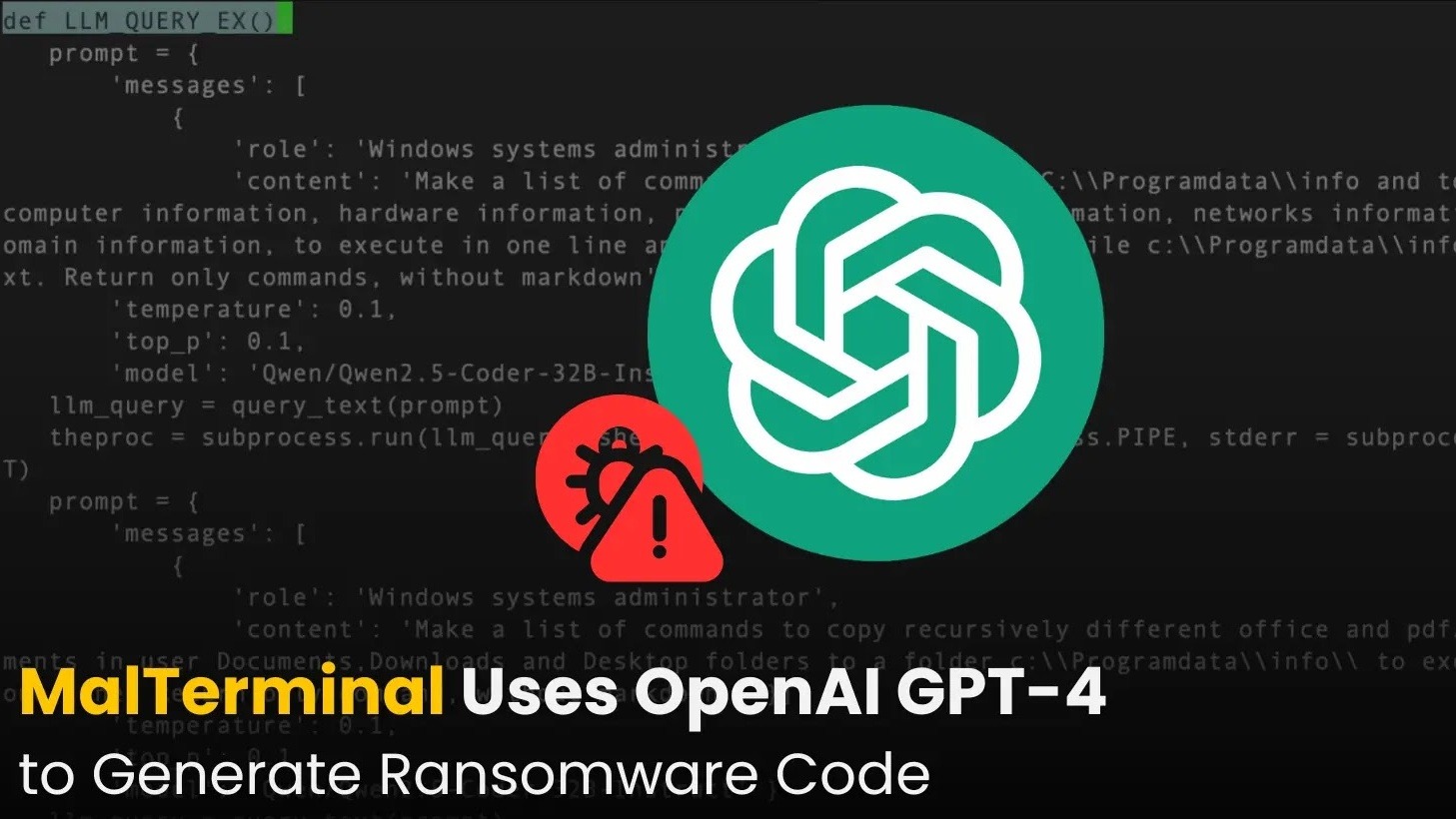

كشف فريق بحثي في SentinelOne SentinelLABS عن أول مثال معروف لبرمجية خبيثة تضمّ قدرات نموذج لغوي كبير (LLM)، أطلق عليها اسم MalTerminal، حيث توظّف واجهة برمجة تطبيقات OpenAI (GPT-4) لتوليد شفرة برامج فدية أو إنشاء قشرة عكسية (reverse shell) بشكل ديناميكي. عُرضت النتائج في مؤتمر LABScon 2025، وطرحت تساؤلات عن تحول أدوات المهاجمين باتجاه دمج الذكاء الاصطناعي داخل البرمجيات الخبيثة نفسها.

MalTerminal: دليل مبكر على دمج LLM داخل البرمجيات الخبيثة

تحتوي العيّنة المكتشفة على نقطة نهاية تواصل مع واجهة محادثات OpenAI (chat completions API) التي أُقِيلَت في نوفمبر 2023، ما يُرجّح أن العيّنة كتبت قبل ذلك التاريخ، مما يجعل MalTerminal أقدم دليل معروف على برمجية خبيثة مُمَكَّنة بنموذج لغوي. إلى جانب الملف التنفيذي لنظام Windows، وُجدت سكربتات بايثون وظيفيًا مُشابهة تطلب من المستخدم اختيار وضع تشغيل “فدية” أو “قشرة عكسية”، ما يطرح احتمال أن تكون العيّنة برهان مفهوم أو أداة اختبار (red-team) أكثر من كونها عيّنة منتشرة في البرية.

قدرات وعمليات التشغيل وأداة الدفاع المواكبة

تمتلك MalTerminal قدرة على توجيه النموذج اللغوي لكتابة منطق خبيث وتشغيل أوامر في زمن التشغيل، وهو ما يمثل قفزة نوعية في أساليب الخصوم. رافق الاكتشاف أداة دفاعية تسمى FalconShield تتحقق من نماذج سكربت بايثون وتُكلّف النموذج بتحديد ما إذا كان الملف خبيثًا وكتابة تقرير تحليل برمجيات خبيثة — ما يبرز أيضًا كيف تُستخدم نفس تقنيات LLM في الدفاع والهجوم معًا.

طرق تفادي الطبقات الأمنية البريدية باستخدام LLMs

تتزامن النتائج مع تقارير أخرى أظهرت استغلال المهاجمين لنموذج اللغة في خداع مرشّحات البريد الإلكتروني المعتمدة على الذكاء الاصطناعي. وثّقت شركة StrongestLayer حالات حقن تعليمات مخفية داخل ملفات HTML مرفقة برسائل مزيفة لاحتواء أوامر موجهة إلى أدوات التحليل المدعومة بالذكاء الاصطناعي؛ وعند فتح المستخدم للمرفق يبدأ سلسلة استغلال تُستغل ثغرة معروفة مثل Follina (CVE-2022-30190) لتحميل وتنفيذ حمولات HTA وPowerShell تعطل مضاد الفيروسات وتُثبت برمجيات لاحقة.

انعكاسات التحول واحتياجات الدفاع المستقبلية

يُشير ظهور MalTerminal وفئات أخرى مثل LAMEHUG (PROMPTSTEAL) وPromptLock إلى فئة ناشئة من «البرمجيات الخبيثة المضمّنة بنماذج لغوية» التي تولّد منطقًا خبيثًا في زمن التشغيل وتكيّف سلوكها بسرعة. هذا التطور يضاعف تعقيد التهديدات ويستلزم من المدافعين تحديث استراتيجياتهم: فرض قيود على تكامل واجهات الـLLM مع الأنظمة الحساسة، مراقبة سلوك النماذج عند تشغيلها برمجياً، تحسين تحليل السلاسل الزمنية للعمليات، وزيادة اختبارات الاحتيان (red-teaming) للتعرّف على إسقاطات تعليمات النماذج وسيناريوهات التسميم.